中風癱瘓18年 AI讓她再次「开口說話」:腦機接口模擬表情 數字化身當嘴替

2023-08-26 15:00 新智元

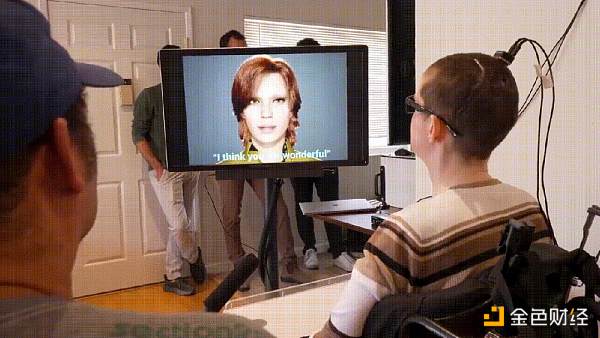

【導讀】中風‍後,癱瘓的Ann失語了18年。就在最近,腦機接口和數字化身,竟讓她能用面部表情「說話」了。

同一天,Nature雙發「腦機接口」重磅研究,足以改變整個人類!

30歲那年,一次毀滅性的中風,讓一位47歲加拿大女性幾乎完全癱瘓,此後失語18年。

幸運地是,來自加州大學的團隊开發了全新腦機接口(BCI),讓Ann控制「數字化身」再次开始說話了。

「I think you are wonderful」,當這句話說出口時,對於Ann來說,足足跨越了十多年。

值得一提的是,這個數字化身中面部表情實現,採用了「最後生還者 2」同樣的技術。

具體來講,研究人員在Ann的大腦表層下,植入一系列電極。

當Ann試圖說話時,BCI便會攔截大腦信號,將其轉化爲單詞、語音。這裏,AI不是去解碼整個單詞,而是解碼音素。

加州大學的BCI實現了能夠以每分鐘78個單詞的速度說話,遠遠超過Ann曾經帶過的設備,即每分14個單詞。

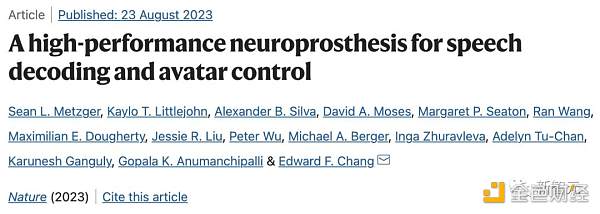

正如論文題目所示,研究關鍵實現了「語音解碼」和「數字化身控制」,也正是與以往研究最大的不同。

全新的BCI技術通過面部表情,爲數字化身Avatar制作動畫,以模仿人類自然交流的細節。

論文地址:https://www.nature.com/articles/s41586-023-06443-4

這項突破性的研究於8月23日在Nature發表。這是首次,直接從大腦信號合成語音和面部動作,標志着腦機接口的一大飛躍。

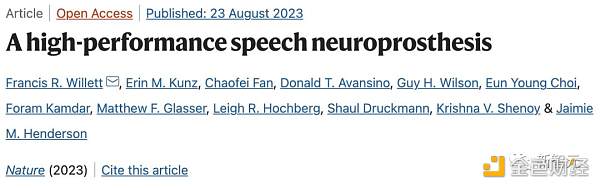

另一篇登上Nature的研究,同樣是關注將語音神經活動轉化爲文字的腦際接口。

研究結果稱,癱瘓患者能夠以每分62個字的速度進行交流,比之前的研究快3.4倍。

論文地址:https://www.nature.com/articles/s41586-023-06377-x

兩項重磅研究,全都將語音大腦信號轉成文本的速度大幅提升,甚至還讓虛擬化身做人類「嘴替」。

創世的腦機接口,讓人類離機械飛升不遠了。

第一句話出口時,她幸福地笑了

三十而立,對於每個人來說,人生還有許多驚喜需要开啓。

對於Ann來說,作爲加拿大的一名高中數學老師,正在講台上教書育人,桃李滿天下。

然而,突如其來的一場中風,讓她瞬間失去對身體所有肌肉的控制,甚至無法呼吸。

從此,她再也沒有說出一句話。

腦中風最直接的後果,就是無法控制面部肌肉,導致面癱,無法說話。

在接下來的5年裏,Ann經常輾轉難眠,害怕自己會在睡夢中死去。

經過多年的物理治療,也看到了一些初步成果。

她能夠做出有限的面部表情,以及一些頭部和頸部運動,盡管如此,她依舊無法驅動面部說話的肌肉。

爲此,她也接受了腦機接口的手術。

不過以往的BCI技術不夠先進,只能讓Ann進行艱難緩慢的交流,無法將她的大腦信號解碼爲流利的語言。

Ann輕輕移動頭部,通過設備在電腦屏幕上緩慢地打字,「一夜之間,我的一切都被奪走了。」

2022年,Ann決定再次做出嘗試,自愿成爲加州大學研究團隊的受試者。

添加一張臉,一個聲音

對此,研究人員記錄了Ann試圖背誦單詞時的大腦信號模式,以訓練人工智能算法識別各種語音信號。

值得一提的是,訓練的AI是來解碼音素——語音的基本要素,而不是整個單詞,使其速度和通用性提高了3倍。

爲了做到這一點,研究小組在安的大腦表面植入了一個由253個電極組成薄如紙片的矩形電極。

然後,由一根電纜插入Ann頭部固定的端口,將電極連接到一組計算機上。

這一系統,現在能以每分近80個單詞的速度將Ann的嘗試語音轉錄成文本,遠遠超過了她以前的BCI設備的速度。

通過Ann在2005年的婚禮錄像,研究團隊利用人工智能重建了一個人獨特的語調和口音。

然後,他們利用一家致力於語音生成動畫技術公司Speech Graphics开發的軟件創建了一個個性化數字化身,能夠實時模擬Ann的面部表情。

他能夠與Ann試圖說話時大腦發出的信號相匹配,並將這些信號轉換成她的化身面部動作。

包括下巴張开和閉合、嘴脣撅起和抿緊、舌頭上翹和下垂,以及快樂、悲傷和驚訝的面部動作。

現在,當Ann嘗試說話時,數字化身就會無縫地制作動畫,並說出她想要的話。

這裏,著名的冒險遊戲「最後生還者 2」「光環:無限」等在呈現生動多樣的人物面部表情時,同樣使用了Speech Graphics的面部捕捉技術。

Speech Graphics的首席技術官兼聯合創始人Michael Berger表示:

創建一個可以實時說話、表情和表達的數字化身,並直接與受試者的大腦相連,顯示了人工智能驅動面部的潛力遠遠超出了視頻遊戲。

僅恢復說話本身就令人印象深刻,而面部交流是人類的固有特性,它讓患者再次擁有了這個非凡的能力。

加州大學的這項研究工作不僅僅是BCI技術突破,更是無數特殊人士的希望。

這項技術突破讓個人實現獨立,自我表達觸手可及,爲Ann和無數因癱瘓而失去語言能力的人,帶去了前所未知的希望。

對於Ann如今13個月大的女兒來說,BCI突破讓她聽到了,從誕生起,從未聆聽過的母親的聲音。

據介紹,他們开發的下一個BCI版本,是無线的,省去了連接到物理系統的麻煩。

加州大學這項實驗領導者Edward Chang已經用了十多年的時間推進腦機接口技術。

2021年,他和他的研究團隊开發了一種「語言神經科技輔具」(speech neuroprosthesis),讓一名嚴重癱瘓的男子能夠用完整的句子進行交流。

這項技術,能捕捉大腦指向聲道的信號,並將其轉化爲文字顯示在屏幕上,標志着首次證明了語音-大腦信號可以被解碼爲完整的單詞。

那么,加州大學讓Ann「开口說話」的背後技術具體是如何實現的呢?

技術實現

在這項研究中,由加州大學舊金山分校神經外科主任Edward Chang博士領導的研究團隊將253針電極陣列植入了Ann的大腦語言控制區。

這些探頭監測並捕獲了神經信號,並通過頭骨中的電纜端口將它們傳輸到一組處理器中,在這個計算堆棧( computing stack)中有一個機器學習AI。

幾周來,Ann與團隊合作訓練系統的人工智能算法,以識別她的大腦中1000多個單詞的神經信號模式。

這需要一遍又一遍地重復1,024個單詞的會話詞匯中的不同短語,直到計算機識別出與所有基本語音相關的大腦活動模式。

研究人員沒有訓練AI識別整個單詞,而是創建了一個系統,可以從音素的較小組件中解碼單詞。音素以與字母形成書面單詞相同的方式形成口語。例如,「Hello」包含四個音素:「HH」、「AH」、「L」和「OW」。

使用這種方法,計算機只需要學習39個音素,就可以破譯英語中的任何單詞。這既提高了系統的准確性,又使速度提高了三倍。

但這只是研究的一個小序曲,重頭戲在AI對Ann意圖的解碼和映射。

電極被放置在大腦區域,研究小組發現這些區域對語言至關重要

研究團隊通過深度學習模型,將檢測到的神經信號映射到語音單元、語音特徵,以輸出文本、合成語音和驅動虛擬人物。

剛剛提到,研究人員與Speech Graphics公司合作制作了患者的虛擬形象。

SG的技術根據對音頻輸入的分析,「逆向設計」出面部必要的肌肉骨骼動作,然後將這些數據實時輸入遊戲引擎,制作成一個無延遲的形象。

由於病人的精神信號可以直接映射到化身上,因此她也可以表達情感、甚至進行非語言交流。

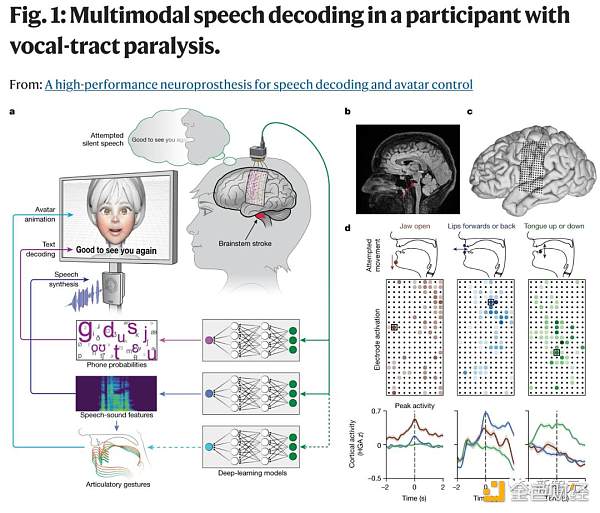

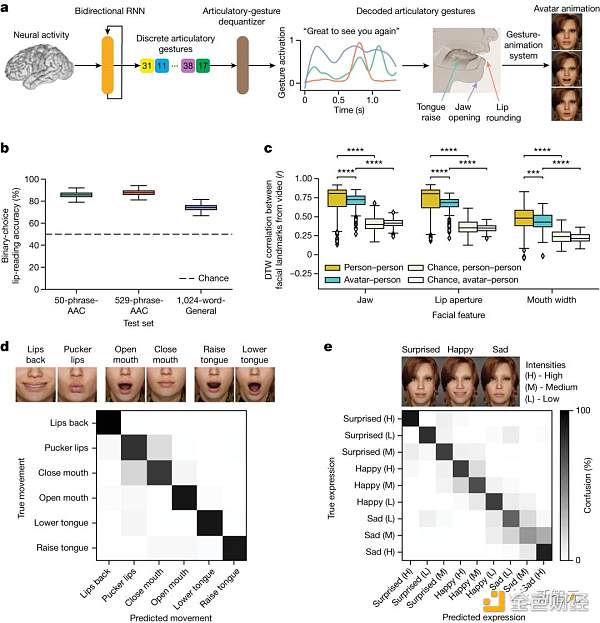

多模態語音解碼系統概述

研究人員設計了一個語音解碼系統,幫助因嚴重癱瘓和無法發聲的Ann重新與他人進行溝通交流。

Ann與團隊合作訓練AI算法,以識別與音素相關的大腦信號(音素是形成口語的語音亞單元)

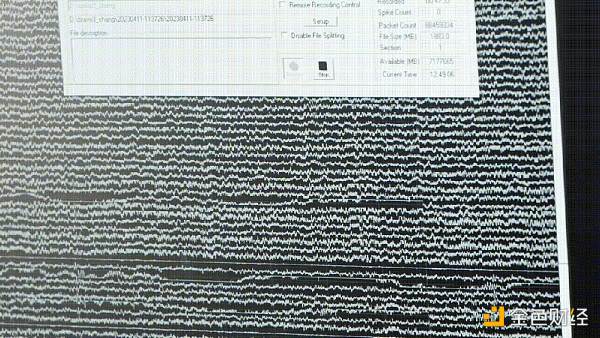

研究人員在Ann的大腦皮層上植入了一個有253個通道的高密度ECoG陣列,特別是覆蓋了與語言有關的大腦皮層區域,包括SMC和顳上回。

簡單來說,這些區域與研究人員的面部、嘴脣、舌頭和下巴的動作有關 (1a-c)。

通過該陣列,研究人員可以檢測到這些區域在Ann想要說話時的電信號。

研究人員注意到當Ann嘗試移動她的嘴脣、舌頭和下巴時,陣列可以捕獲到不同的激活信號 (1d)。

爲了研究如何從大腦信號中解碼語言,研究人員讓Ann在看到屏幕上的句子後嘗試無聲地說出這個句子,即做出發音的動作。

研究人員從Ann頭部的253個ECoG電極捕獲到的信號中,提取了兩種主要的大腦活動信號:高伽瑪活動(70-150赫茲)和低頻信號(0.3-17赫茲)。

隨後便使用了深度學習模型去學習如何從這些大腦信號中預測發音、語音和口腔動作,最終將這些預測轉化爲文本、合成語音和虛擬化身的動作。

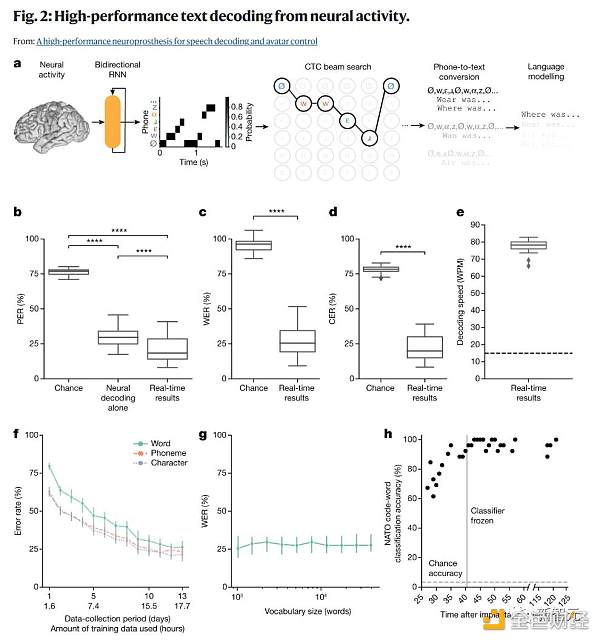

文本解碼

研究團隊希望從大腦中解碼文本,特別是在患有發音困難的人嘗試說話的情況下。

但他們早期的努力遭遇了解碼速度慢和詞匯量小的限制。

本研究中,他們使用了電話解碼(phone decoding)的方法,這使他們能夠從大詞匯量中解碼任意短語,並實現接近自然說話的速度。

爲了評估實時性能,當Ann嘗試默讀249個句子時,研究團隊解碼了文本。這些句子是從一個包含1024個單詞的句子集中隨機選擇的,並且在模型訓練時並未使用過。爲了解碼,他們從ECoG信號中提取了特徵,並使用了雙向循環神經網絡(RNN)進行處理。

他們使用了幾個標准指標來評估解碼性能,包括單詞錯誤率(WER)、電話錯誤率(PER)、字符錯誤率(CER)和每分鐘單詞數(WPM)。

研究團隊觀察到,當解碼速度爲78.3 WPM時,這已經超過了Ann使用其輔助設備的通常通信速度,並且接近自然說話的速度。

爲了評估信號的穩定性,他們進行了一個單獨的任務,要求Ann默讀NATO的26個代碼詞或嘗試進行四種手勢動作。結果顯示,神經網絡的分類器性能非常好,平均准確率高達96.8%。

最後,爲了評估在沒有任何單詞之間暫停的情況下對預定義句子集的模型性能,他們對兩個不同的句子集進行了模擬解碼,結果顯示對於這些經常被用戶使用的有限、預定義的句子,解碼速度非常快且准確性非常高。

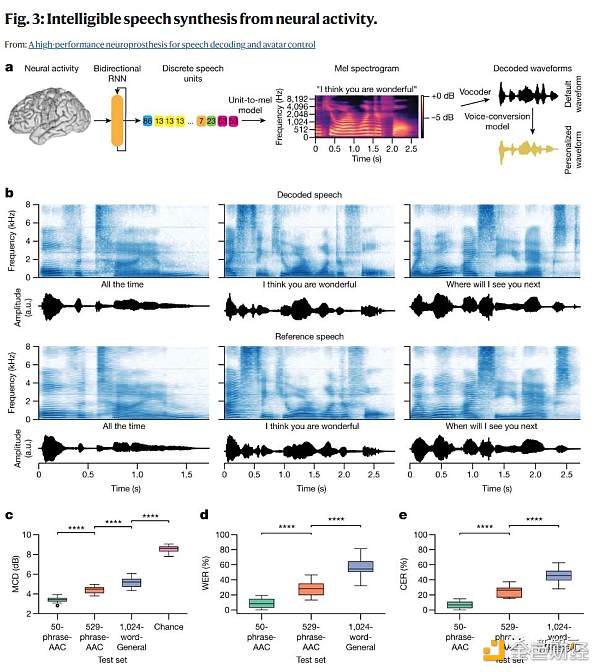

語音合成

文本解碼的另一種方法是直接從記錄的神經活動中合成語音,這可以爲無法說話的人提供一條更自然、更有表現力的交流途徑。

以前對言語功能完好的人進行的研究表明,在發聲或模仿說話時,可以通過神經活動合成可理解的語音,但這種方法尚未在癱瘓者身上得到驗證。

研究人員將在音頻-視覺任務條件下試圖默讀時的神經活動直接轉化爲可聽見的語音進行了實時語音合成(圖3a)。

爲了合成語音,研究人員將神經活動的時間窗口傳遞到一個雙向循環神經網絡(RNN)中。

在測試之前,研究人員訓練RNN預測每個時間步驟的100個離散語音單元的概率。

爲了創建訓練的參考語音單元序列,研究人員使用了HuBERT,這是一個自監督的語音表示學習模型,它將連續的語音波形編碼爲捕獲潛在音位和發音表示的離散語音單元的時間序列。

在訓練過程中,研究人員使用了CTC損失函數,使RNN能夠在沒有參與者的靜默言語嘗試和參考波形之間的對齊的情況下,學習從ECoG特徵到這些參考波形中派生的語音單元之間的映射。

在預測了單元概率後,將每個時間步的最可能單元傳入一個預先訓練的單元到語音模型中,該模型首先生成一個梅爾頻譜圖,然後會實時將該梅爾頻譜圖合成爲聽得見的語音波形。

在離线情況下,研究人員使用了一個在參與者受傷之前的短時間段內訓練的語音轉換模型,將解碼的語音處理成參與者自己的個性化合成聲音。

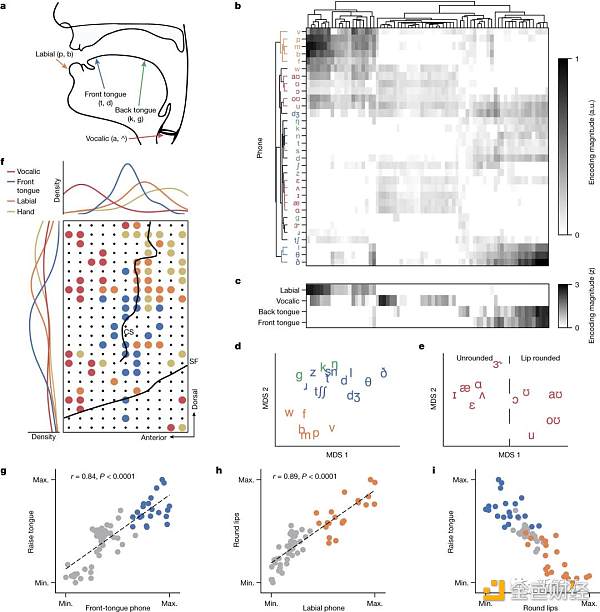

面部頭像解碼

研究人員开發了一種面部化身BCI界面,用於將神經活動解碼成發音的語音手勢,並在視聽任務條件下呈現出動態的虛擬面部(圖4a)。

研究人員爲了實現合成面部頭像的動態動畫,採用了一個被設計來將語音信號轉化爲面部動作動畫的頭像動畫系統(Speech Graphics)。

研究者採用了兩種辦法來爲頭像制作動畫:直接方法和聲學方法。直接方法是從神經活動中直接推測發音動作,不通過任何語音中介。

聲學方法則用於實時音視頻合成,它確保解碼的語音音頻和頭像的動作之間達成低延遲同步。

除了伴隨合成語音的發音動作外,完整的頭像腦機接口還應該能夠顯示與語音無關的口面動作和表達情感的動作。

爲此,研究者收集了參與者在執行額外兩項任務時的神經數據,一是發音動作任務,二是情感表達任務。

結果顯示,參與者可以控制頭像BCI來顯示發音動作和強烈的情感表達,這揭示了多模態通信腦機接口恢復表達有意義的口面動作的潛力。

發音表徵驅動解碼

在健康的說話者中,SMC(包括前中央回和後中央回)的神經表徵編碼了口面肌肉的發音動作。

將電極陣列植入到參與者的SMC中心時,研究人員推測:即使在癱瘓後,發音的神經表示仍然存在,並且推動了語音解碼的性能。

爲了評估這一點,研究者擬合了一個线性的時間感受場編碼模型,根據在1024字通用文本任務條件下,文本解碼器計算的音素概率來預測每個電極的HGA。

對於每一個被激活的電極,研究者計算了每個音素的最大編碼權重,從而得到了一個音位調諧空間。在這個空間中,每個電極都有一個與其相關的音素編碼權重向量。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:中風癱瘓18年 AI讓她再次「开口說話」:腦機接口模擬表情 數字化身當嘴替

地址:https://www.sgitmedia.com/article/8823.html

相關閱讀:

- AI智能體解決代幣預售問題?一文讀懂AI-Pool 2024-12-24

- DePayFi: 任何資產、任何時間、任何地方都能增值 2024-12-24

- AI Agent未來的敘事方向在哪裏? 2024-12-24

- 2025年是時候認真了解下加密貨幣了 2024-12-24

- 馬斯克xAI融資438億 黃仁勳蘇姿豐都投了 2024-12-24

- 華爾街“認同”美聯儲:預測2年期美債收益率明年將下降50個基點 2024-12-24

- 馬斯克2024年終總結:他都創造了哪些記錄? 2024-12-24

- Web3律師:2025 Web3投資新風口-AI加密基金的潛力與合規挑战 2024-12-24