Vitalik:我如何看待加密和AI交叉領域及其前景和挑战

2024-01-31 08:43 金色財經

Vitalik:我如何看待加密和AI交叉領域及其前景和挑战

金色財經

企業專欄

剛剛

金色財經

企業專欄

剛剛

作者:Vitalik;翻譯:金色財經xiaozou

多年來,有很多人問過我一個類似的問題,那就是我認爲加密和人工智能之間最具成效的交集在哪裏?這個問題很好:加密和人工智能可以說是上個十年裏最主要的兩個深度(軟件)技術趨勢,二者之間一定存在着某種聯系。我們很容易發現表面上的協同效應:加密去中心化可以平衡人工智能的中心化問題,人工智能是不透明的,加密則帶來了透明度,人工智能需要數據,而區塊鏈非常適合存儲和跟蹤數據。但多年來,當人們要我進行深入研究並聊聊具體的應用程序時,我的回答總會讓他們失望:“確實,是有一些深度的東西,但不是很多”。

過去三年裏,隨着現代LLM(機器學習模型)形式的更強大的人工智能的興起,以及更強大的加密貨幣——不僅是區塊鏈擴展解決方案形式,還有ZKP、FHE、(雙方和n方)MPC形式——的興起,我开始看到了變化。在區塊鏈生態系統中確實存在一些前景光明的人工智能應用,或是人工智能與密碼學相結合的應用,重要的是要關注人工智能的應用方式。其中一個具體的問題就是:在密碼學裏,开源是確保某些東西真正安全的唯一途徑,但在人工智能領域,开源模型(甚至連訓練數據也是开源的)卻大大加劇了它面對對抗性機器學習攻擊的脆弱性。本文將介紹加密與人工智能之間可能存在的各類交集及其前景和挑战。

四大類AI

人工智能是一個非常寬泛的概念:你可以把“人工智能”想象成一組算法,而非具體的設定,就像是通過攪拌一大鍋神奇的計算的湯汁,並施加某種優化壓力,來讓這鍋湯提供給你帶有你想要的屬性的算法。這種描述絕對不應該被看輕:它就是我們人類最初誕生的過程!人工智能算法確有一些共同的特性:它們的做事能力非常強大,而與此同時,我們窺探幕後真相的能力也非常有限。

人工智能的分類方式有很多。本文主要討論人工智能和區塊鏈(被描述爲創建“遊戲”的平台)之間的交集,所以我將人工智能在此進行如下分類:

遊戲玩家類AI(最易存活):AI所參與的機制中,激勵的最終來源出自協議的人類輸入。

遊戲界面類AI(潛力巨大,但也存在風險):AI幫助用戶理解他們身邊的加密世界,並確保他們的行爲(如:籤署消息和交易)與他們的意圖相符,他們不會被欺騙。

遊戲規則類AI(如履薄冰):區塊鏈、DAO和其他類似機制直接調用AI。例如“AI法官”。

遊戲目標類AI(長期但有趣):設計區塊鏈、DAO和其他類似機制,目的是構建和維護一個可用於其他目的的AI,使用加密bits來更好地激勵訓練或防止AI泄露隱私數據或被濫用。

1、遊戲玩家類AI

遊戲玩家類AI實際上是一個已經存在了近十年的類別,尤其是自從鏈上去中心化交易所(DEX)开始被廣泛使用以來。只要涉及到交易,就會有套利賺錢的機會,而機器人在套利方面比人類更具優勢。這個用例已經存在很久了,雖然使用的AI比現今的AI簡單的多,但它最終成爲了人工智能與加密貨一個真正的交叉領域。最近我們經常看到MEV套利機器人相互競爭。無論什么時候,只要區塊鏈應用程序涉及到拍賣或交易,都會出現套利機器人。

然而,AI套利機器人僅僅是其所在的更大範疇裏的第一個例子,我預計很快還會包含很多其他應用。

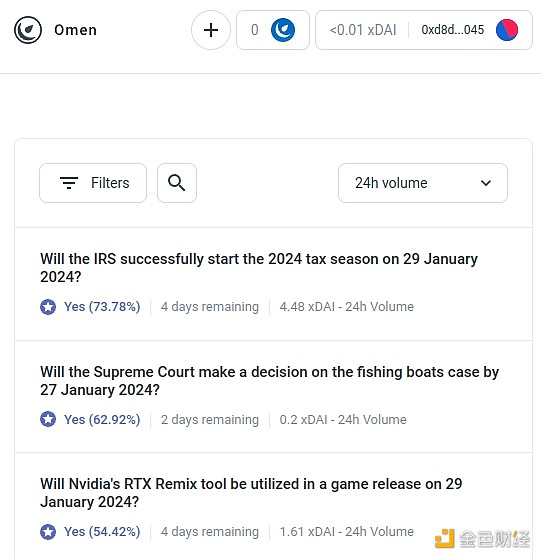

長期以來,預測市場一直是認知技術的聖杯;早在2014年,我就對使用預測市場作爲治理輸入非常興奮,上次大選和最近的選舉就廣泛使用了預測市場。但到目前爲止,預測市場在實踐中並沒有太大的發展,常見的原因有很多:最大的參與者往往是非理性的,明智的人往往不愿花費時間下注,除非涉及到大量資金,還有市場的流動性很淺,等等。

對此有一種回應指向了Polymarket或其他新興預測市場正在進行的用戶體驗改進,並希望它們能夠在之前失敗的地方獲取成功。畢竟,故事都是這樣發展的,人們愿意在體育賽事上押注數百億美元,那么爲什么不把足夠的錢押注在美國大選或LK99上,這樣一來,那些大玩家也就會有入場意愿了。但這一點必須面對這樣一個事實,那就是既然之前都未能達到這種規模(至少與其支持者的夢想相比),因此似乎需要一些新的東西才能讓使預測市場成功。所以,另一種不同的回應指向了預測市場生態系統的一個具體特徵,也就是我們可以在21世紀20年代看到上個年代看不到的東西:人工智能無所不在的可能性。

人工智能愿意以每小時不到1美元的價格工作,並且擁有百科全書般的知識——如果這還不夠,它們甚至還可以與實時網絡搜索功能相結合。如果你做市,並提供50美元的流動性補貼,人類可能不太在意,不會去競標,但成千上萬的人工智能會迅速行動,並盡其所能做出最好的預測。在一個問題表現出色的激勵可能很小,但讓人工智能做出廣泛的正確預測的激勵卻很巨大。請注意,你甚至不需要人類來對大多數問題實行裁決:你可以使用類似於Augur或Kleros的多輪爭議系統,其中人工智能也將參與較早的輪次。人類只需要在非常少數情況下做出反應,也就是當進行一系列雙方投入都很大的升級的時候。

這是一個強大的原語,因爲一旦“預測市場”可以進行如此微觀規模的工作,你就可以在許多其他類問題上重復使用“預測市場”原語:

根據[用戶使用條款],這個社交媒體帖子是否可以發布?

股票X的價格會發生什么變化?

現在正發消息給我的這個账號真的是埃隆·馬斯克嗎?

這個在在线任務市場提效的工作合格嗎?

這個網址是https://examplefinance.network的dapp是個騙局嗎?

0x1b54....98c3真的是“Casinu Inu” ERC20代幣的地址嗎?

你可能會注意到,這些想法很多都是朝着我所說的“信息防御”的方向發展的。從廣義上講,問題是:我們如何幫助用戶區分真實和虛假信息,檢測詐騙,而不是授權一個中心化權威機構來決定孰是孰非,因爲中心化權威可能會濫用自己的權利。在微觀層面上,答案可以是“人工智能”。但在宏觀層面上,要面臨的問題是:誰來建設人工智能?人工智能是其創建過程的反映,是無法避免偏見的。所以,我們需要一個更高層的遊戲去評判各種AI的表現,讓AI能夠作爲玩家參與到遊戲中。

人工智能的這種使用,即人工智能參與某種機制,並最終會被一個匯集人類輸入的鏈上機制(稱之爲基於市場的去中心化RLHF如何?)獎勵或懲罰,我認爲這是一個真正值得研究的方向。現在是時候更多地研究這樣的用例了,因爲區塊鏈擴展終於成功了,讓任何“小”、“微”事物終於在鏈上可行,而這些在之前通常是不可行的。

一個相關的應用類別就是高度自主的使用區塊鏈實現更優合作的智能體,不管是通過支付還是通過使用智能合約來做出可信承諾。

2、遊戲界面類AI

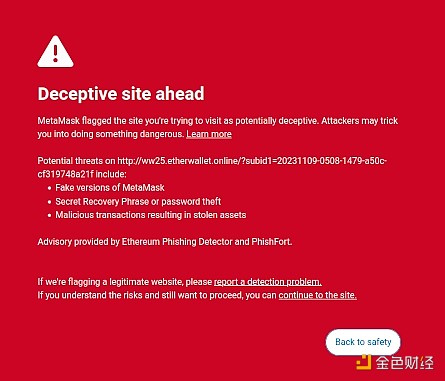

我曾在自己的文章中提出的一個想法是,編寫面向用戶的軟件是有市場機會的,這種軟件可以通過解釋和識別用戶正在瀏覽的线上世界中的危險來保障用戶的利益。一個業已存在的例子就是Metamask的欺詐檢測功能:

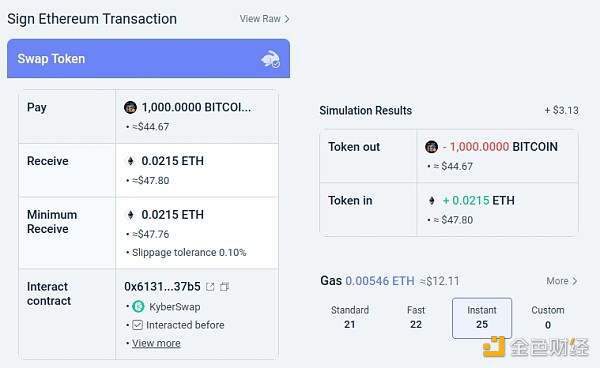

另一個例子就是Rabby錢包的模擬功能,它向用戶展示他們即將籤署的交易的預期結果。

另一個例子就是Rabby錢包的模擬功能,它向用戶展示他們即將籤署的交易的預期結果。

這些工具可能會被人工智能大大強化。人工智能可以提供一個更豐富的人類友好的解釋,說明你正在參與什么樣的dapp,你正在籤署的復雜操作的後果,特定的代幣是否真實(例如,BITCOIN不僅僅是一串字符,它還是一種真正的加密貨幣的名稱,它不是ERC20代幣,其價格遠遠高於0.045美元,LLM會知道這一點),等等。有些項目开始朝着這個方向發展(例如LangChain錢包使用AI作爲主界面)。我個人的觀點是,純AI界面目前可能風險太大,因爲它會增加發生其他類型錯誤的風險,但用AI來補足偏向傳統的界面是極其可行的。

這些工具可能會被人工智能大大強化。人工智能可以提供一個更豐富的人類友好的解釋,說明你正在參與什么樣的dapp,你正在籤署的復雜操作的後果,特定的代幣是否真實(例如,BITCOIN不僅僅是一串字符,它還是一種真正的加密貨幣的名稱,它不是ERC20代幣,其價格遠遠高於0.045美元,LLM會知道這一點),等等。有些項目开始朝着這個方向發展(例如LangChain錢包使用AI作爲主界面)。我個人的觀點是,純AI界面目前可能風險太大,因爲它會增加發生其他類型錯誤的風險,但用AI來補足偏向傳統的界面是極其可行的。

值得一提的還有一個特定風險。我將在下面的“遊戲規則類AI”部分內容中詳細討論這個問題,但一般性的問題是對抗性機器學習:如果用戶可以訪問开源錢包中的AI助手,那么不良人員也可以訪問該AI助手,因此他們將有無限的機會優化他們的騙局,避免觸發錢包防御。所有現代AI都有bug,這對於訓練過程來說發現bug並不難,即使只有有限的模型訪問權限。

這就是“人工智能參與鏈上微市場”更能施展的地方:所有AI能都容易遭受相同的風險,但你有意創建一個开放的生態系統,由數十人不斷進行迭代和改進。此外,每個單獨的AI都是閉環的:系統的安全性來自遊戲規則的开放性,而不是每個玩家的內部操作。

小結:人工智能可以用簡單的語言幫助用戶理解正在發生的事情,它可以作爲實時導師,它可以保護用戶免受錯誤的負面影響,但如果想要直接使用人工智能來對付惡意散布虛假信息者和騙子時,一定要小心。

3、遊戲規則類AI

現在,我們談到了讓很多人都很興奮的應用,但我認爲這是最危險的地方,我們需要小心行事:我稱之爲“人工智能成爲遊戲規則的一部分”。這與主流政治精英對“AI法官”的興奮相關,在區塊鏈應用程序中也有類似的愿望。如果基於區塊鏈的智能合約或DAO需要做出主觀決策(例如:某個特定的工作產品是否在僱傭合同範圍內?),你是否可以讓人工智能成爲合約或DAO的一部分,以幫助執行這些規則?

這就是爲什么說對抗性機器學習將成爲一個極其艱巨的挑战。基本的兩句話論證如下:

如果在機制中扮演關鍵角色的AI模型是閉環的,則無法驗證其內部工作原理,所以它並不比中心化應用程序更好。如果AI模型是开源的,那么攻擊者可以下載並在本地模擬它,並設計大量優化的攻擊來欺騙模型,然後在實時網絡上重播。

現在,有些讀者(或加密原住民)可能已經走在我前面了,並且在想:等等!我們有了不起的零知識證明和其他非常酷的密碼學手段。當然,我們可以施一些加密魔法,隱藏模型的內部工作原理,這樣攻擊者就無法優化攻擊,而與此同時證明模型正在被正確執行,並且是在合理的底層數據集上使用合理的訓練過程構建的!

通常,這正是我在其他文章中所提倡的思維方式。但對AI相關計算而言,還有兩個主要的反對意見:

加密开銷:在SNARK(或MPC……)內部執行某些操作的效率要比透明化執行低得多。考慮到人工智能已經是非常密集的計算,在加密黑盒中進行人工智能計算可行嗎?

黑盒對抗性機器學習攻擊:即使不了解模型的內部工作原理,也有辦法優化針對AI模型的攻擊。如果你隱藏得太多,你就有可能讓選擇訓練數據的人很容易用有毒攻擊來破壞模型。

二者都是復雜的兔子洞,所以讓我們來依次探查。

(1)加密开銷

加密工具,特別是像ZK-SNARKs和MPC這樣的通用工具,开銷很高。客戶端直接驗證一個以太坊區塊需要幾百毫秒,但生成一個ZK-SNARK來證明這樣一個區塊的正確性卻可能需要幾個小時。其他加密工具(如MPC)的通常开銷可能更大。人工智能計算已經相當昂貴:最強大的LLM輸出單個單詞的速度只比人類閱讀單詞的速度快一點點,更不用說訓練這些模型常常需要數百萬美元的計算成本。頂級模型和試圖節省更多訓練成本或參量數的模型之間的質量差異很大。乍一看,這是一個很好的質疑理由,懷疑整個項目試圖通過將AI包裹在密碼學中來強化保障。

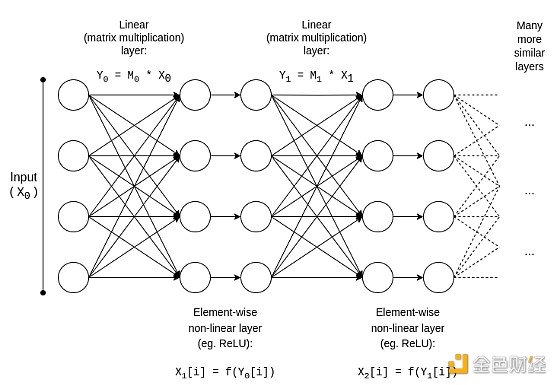

幸運的是,人工智能是一種結構非常具體的計算類型,這使得它能夠適應各種優化,而像ZK-EVM這樣的“非結構化”計算類型卻無法從這些優化中受益。讓我們來看看人工智能模型的基本結構:

通常,AI模型主要由一系列矩陣乘法組成,其中穿插着各元素的非线性運算,如ReLU函數(y = max(x, 0))。矩陣乘法佔據了工作的大部分:將兩個N*N矩陣相乘需要時間,而非线性運算的數量要少得多。這對於密碼學來說非常方便,因爲很多形式的密碼學都幾乎可以“免費”地進行线性運算(矩陣乘法是线性運算,如果你只加密模型而不加密它的輸入的話)。

通常,AI模型主要由一系列矩陣乘法組成,其中穿插着各元素的非线性運算,如ReLU函數(y = max(x, 0))。矩陣乘法佔據了工作的大部分:將兩個N*N矩陣相乘需要時間,而非线性運算的數量要少得多。這對於密碼學來說非常方便,因爲很多形式的密碼學都幾乎可以“免費”地進行线性運算(矩陣乘法是线性運算,如果你只加密模型而不加密它的輸入的話)。

如果你是一位密碼學家,那么你可能已經聽說過同態加密中的類似現象:在加密的密文上執行加法非常簡單,但執行乘法卻非常困難,直到2009年我們才找到方法來進行無限深度的乘法運算。

對於ZK-SNARKs來說,與此相當的2013年的協議,證明矩陣乘法的开銷不到4倍。遺憾的是,非线性層的开銷最終仍然很大,實踐中最好的實現顯示开銷在200倍左右。但有希望通過進一步的研究,大大減少這方面的开銷。

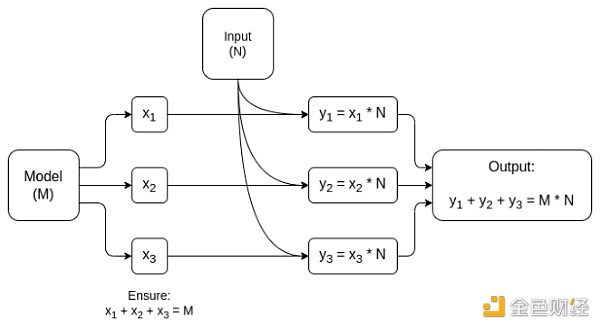

但針對很多應用程序,我們不僅想證明人工智能輸出是計算正確的,我們還想隱藏模型。有一些簡單的方式可以實現這一點:你可以拆分模型,由一組不同的服務器冗余存儲各層,希望泄漏某些層數據的某些服務器不會泄漏太多數據。但還有一些特別有效的多方計算方式。

在這兩種情況下,故事的精神是相同的:AI計算的最重要部分是矩陣乘法,因此可以創建非常高效的ZK-SNARKs或MPC(甚至FHE),所以將AI置入加密盒子的總开銷非常低。一般來說,非线性層是最大的瓶頸,盡管它們的規模較小;也許像Lookup Arguments這樣的新技術會有所幫助。

在這兩種情況下,故事的精神是相同的:AI計算的最重要部分是矩陣乘法,因此可以創建非常高效的ZK-SNARKs或MPC(甚至FHE),所以將AI置入加密盒子的總开銷非常低。一般來說,非线性層是最大的瓶頸,盡管它們的規模較小;也許像Lookup Arguments這樣的新技術會有所幫助。

(2)黑盒對抗性機器學習

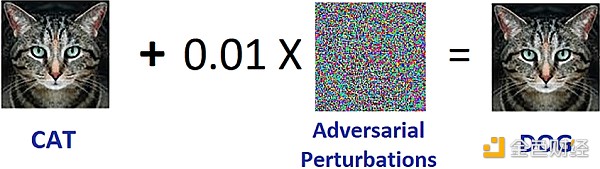

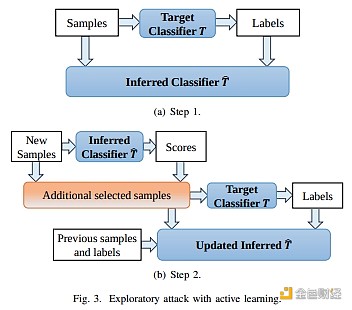

現在,讓我們來討論另一個重大問題:如果模型的內容是私有的,並且你只有對模型的“API訪問”權限,你可以進行哪類攻擊?這裏讓我來引用2016年的一篇文章:

許多機器學習模型很容易受到對抗性示例的影響:專門設計的輸入會導致機器學習模型產生錯誤輸出。能夠影響一個模型的對抗性示例通常會影響另一個模型,即使兩個模型的架構不同或在不同的訓練集上進行訓練,只要兩個模型都被訓練來執行相同的任務就可能受影響。因此,攻擊者可能會訓練自己的替代模型,打磨針對替代模型的對抗性示例,然後將它們用到受害模型中,幾乎無需了解受害模型信息。

有可能,你甚至可以創建只知道訓練數據的攻擊,就算你對試圖攻擊的模型的訪問權限非常有限或沒有任何訪問權限也沒關系。截止到2023年,這類攻擊仍然是一個大問題。

有可能,你甚至可以創建只知道訓練數據的攻擊,就算你對試圖攻擊的模型的訪問權限非常有限或沒有任何訪問權限也沒關系。截止到2023年,這類攻擊仍然是一個大問題。

爲了有效地減少這類黑盒攻擊,我們需要做兩件事:

真正限制誰可以查詢模型以及查詢多少內容。具有不受限制的API訪問權限的黑盒是不安全的;具有非常有限的API訪問權限的黑盒可能是安全的。

隱藏訓練數據,同時確保用於創建訓練數據的過程不會被破壞。

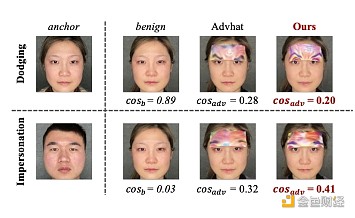

在第一件事上做得最多的項目可能是Worldcoin。Worldcoin在協議層面廣泛使用人工智能模型,以將虹膜掃描轉換爲易於比較相似性的簡短“虹膜代碼”,以及驗證它所掃描的對象實際上是一個人。Worldcoin所依賴的主要防御措施是,它不允許任何人輕易調用人工智能模型,而是使用可信硬件來確保模型只接受由orb相機進行數字籤名的輸入。

這種方法並不一定奏效:事實證明,你可以對生物識別人工智能進行對抗性攻擊,形式是你可以戴在臉上的物理貼片或珠寶:

但希望就是,如果你把所有的防御結合在一起,隱藏人工智能模型本身,極大地限制查詢量,並要求每個查詢進行某種方式的身份驗證,你就可以讓攻擊變得足夠困難,系統就可以是安全的了。

但希望就是,如果你把所有的防御結合在一起,隱藏人工智能模型本身,極大地限制查詢量,並要求每個查詢進行某種方式的身份驗證,你就可以讓攻擊變得足夠困難,系統就可以是安全的了。

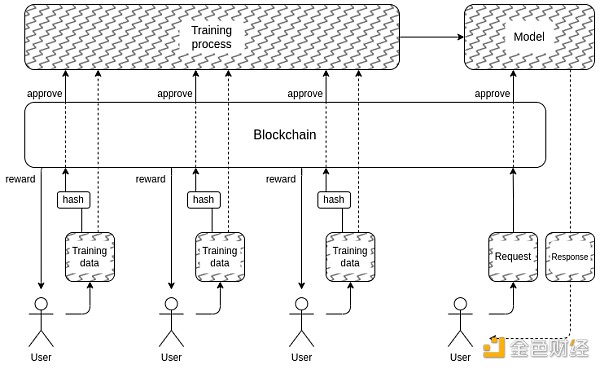

這就將我們帶到了下一件事:我們如何隱藏訓練數據?這可能就是“民主治理AI DAOs”的用武之地:我們可以創建一個鏈上DAO,治理決定如下過程:允許誰提交訓練數據(需要哪些數據相關證明)、允許誰查詢、查詢多少內容、以及使用像MPC等加密技術加密整個AI創建和運行管道(從每個用戶的訓練輸入到每個查詢的最終輸出)。該DAO還可以同時對提交數據的人進行補償。

需要重申的是,這一計劃雄心勃勃,從很多方面來看可能不切實際:

對於這種全黑盒架構來說,加密开銷可能仍然太高,無法與傳統的封閉式的“信任我”的做法相競爭。

結果可能是,沒有一種好的方法可以使訓練數據提交過程去中心化並預防有毒攻擊。

由於參與者串通,多方計算工具的安全或隱私保障可能受損:畢竟,加密貨幣跨鏈橋一次又一次地出現過這種情況。

我之所以沒有在這部分一开始就貼上更大的紅色警告標籤,告訴你“不要做AI法官,這是反烏托邦的”,其中一個原因就是,我們的社會已經高度依賴於不負責任的中心化AI法官:例如,決定社交媒體上哪些帖子和政治觀點會浮出水面或被淹沒(甚至被審查)的那些算法。我確實認爲在這個階段進一步擴大這一趨勢是一個非常糟糕的想法,但我不並認爲區塊鏈社區更多地進行人工智能實驗會使情況變得更糟。

事實上,加密技術有一些非常低風險的基本方法可以使這些現有中心化系統變得更好,我對此非常有信心。有一種簡單的技術通過延遲發布來驗證人工智能:當社交媒體網站基於人工智能對帖子進行排名時,它可以發布一個ZK-SNARK來證明生成該排名的模型的哈希值。該網站可能會承諾在一年後公布其人工智能模型。一旦模型公布,用戶就可以檢查哈希值來驗證是否發布了正確模型,社區可以對模型運行測試來驗證其公平性。發布延遲將確保當模型公开時,它已經過時了。

因此,與中心化世界相比,問題不在於我們是否能做得更好,而是能好多少。然而,對於去中心化世界而言,重要的是要小心謹慎:如果有人構建一個使用人工智能預言機的預測市場或穩定幣,而結果證明這個預言機是可被攻擊的,那么一筆巨大的資金可能會在瞬間消失。

4、遊戲目標類AI

如果上述技術用於創建可擴展的去中心化私有AI,其內容是任何人都不知道的黑盒子,可用於實際運行,那么這也可以用於創建具有超越區塊鏈效用的AI。NEAR協議團隊正將此作爲他們正在進行的工作的核心目標。

這樣做有兩點原因:

如果你可以通過運行使用區塊鏈和MPC的訓練和推理過程來創建“值得信賴的黑箱AI”,那么許多擔心系統有失偏頗或欺騙自己的應用程序都可以從中受益。很多人表達了對我們將依賴的具有系統重要性的AI民主治理的期待;加密和基於區塊鏈的技術可能是實現這一目標的途徑。

從人工智能安全角度來看,這將是一種創建去中心化人工智能的技術,它也有一個自然的終止开關,可以限制那些試圖使用人工智能進行惡意行爲的查詢。

同樣值得注意的是,“使用加密激勵措施來激勵創造更好的AI”可以在不使用密碼學進行完全加密的情況下完成:BitTensor等做法就屬於這一類。

結論

區塊鏈和人工智能都變得越來越強大,在這兩個領域的交叉領域正出現越來越多的用例。然而,其中一些用例相比於其他用例要更有意義,也更強大。通常情況下,當底層機制繼續如以前一樣設計得很粗糙,但個體玩家卻變成了AI,允許機制在更微觀的尺度上有效運行時,用例往往是最有前景的,也是最容易做對的。

嘗試使用區塊鏈和加密技術創建“單一實例”的應用程序將面臨最大的挑战,即創建某些應用程序將依賴之實現某一目標的單個去中心化的可信AI。這些應用程序在功能和提高人工智能安全性方面都是前景光明的,避免了與更加主流的做法相關的中心化風險。但在很多方面,底層假設也可能失敗;所以,需要謹慎行事,特別是在高價值和高風險環境中部署這些應用程序時。

我期待在所有這些交叉領域看到更多人工智能建設性用例的嘗試,這樣我們就可以知道哪些用例是真正可行的。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:Vitalik:我如何看待加密和AI交叉領域及其前景和挑战

地址:https://www.sgitmedia.com/article/22477.html

相關閱讀:

- 盤點2024年的14位加密貨幣支持者與阻礙者 2024-12-26

- Kaiko Research:用10張圖表定義2024年的加密領域 2024-12-26

- 超過中本聰 什么是電子黃金的真義? 2024-12-26

- BTC ETF竟在聖誕前夕流出3.38億美元? 2024-12-26

- 新手入門:投資AI代理領域的基礎知識 2024-12-26

- 盤點2024年加密領域的七位傑出女性 2024-12-26

- 比特幣多頭卷土重來:BTC 衍生品數據暗示漲至 10.5 萬美元 2024-12-26

- 如何預防丟幣? 2024-12-25