OpenAI震撼發布o1大模型 強化學習突破LLM推理極限

2024-09-13 08:53 機器之心

來源:機器之心

大語言模型還能向上突破,OpenAI 再次證明了自己的實力。

北京時間 9 月 13 日午夜,OpenAI 正式公开一系列全新 AI 大模型,旨在專門解決難題。這是一個重大突破,新模型可以實現復雜推理,一個通用模型解決比此前的科學、代碼和數學模型能做到的更難的問題。

OpenAI 稱,今天在 ChatGPT 和大模型 API 中新發布的是該系列中的第一款模型,而且還只是預覽版 ——o1-preview。除了 o1,OpenAI 還展示了目前正在开發的下次更新的評估。

o1 模型一舉創造了很多歷史記錄。

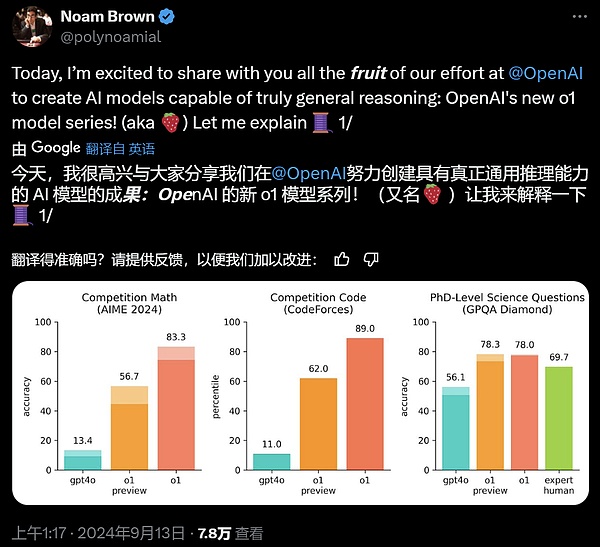

首先,o1 就是此前 OpenAI 從山姆・奧特曼到科學家們一直在「高調宣傳」的草莓大模型。它擁有真正的通用推理能力。在一系列高難基准測試中展現出了超強實力,相比 GPT-4o 有巨大提升,讓大模型的上限從「沒法看」直接上升到優秀水平,不專門訓練直接數學奧賽金牌,甚至能在博士級別的科學問答環節上超越人類專家。

奧特曼表示,雖然 o1 的表現仍然存在缺陷,不過你在第一次使用它的時候仍然會感到震撼。

其次,o1 給大模型規模擴展 vs 性能的曲线帶來了一次上翹。它在大模型領域重現了當年AlphaGo 強化學習的成功 —— 給越多算力,就輸出越多智能,一直到超越人類水平。

也就是從方法上,o1 大模型首次證明了語言模型可以進行真正的強化學習。

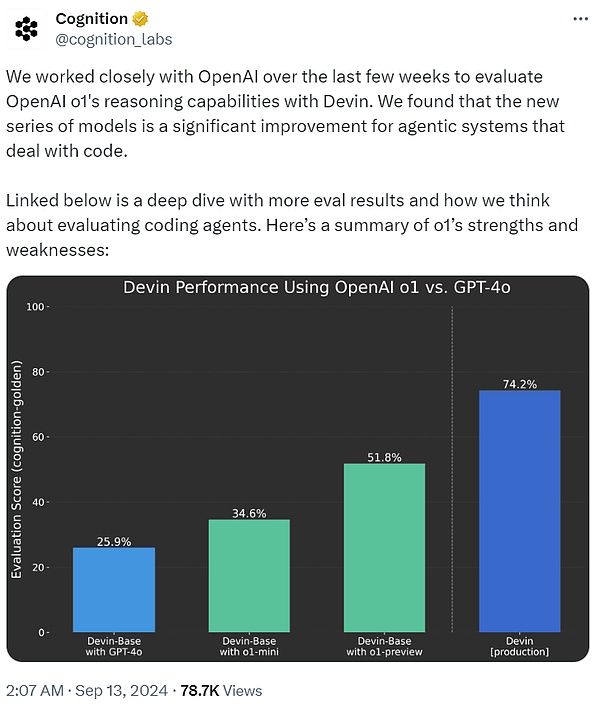

开發出首個 AI 軟件工程師 Devin 的 Cognition AI 表示,過去幾周一直與 OpenAI 密切合作,使用 Devin 評估 o1 的推理能力。結果發現, 與 GPT-4o 相比,o1 系列模型對於處理代碼的智能體系統來說是一個重大進步。

最後在實踐中,o1 上线之後,現在 ChatGPT 可以在回答問題前先仔細思考,而不是立即脫口而出答案。就像人類大腦的系統 1 和系統 2,ChatGPT 已經從僅使用系統 1(快速、自動、直觀、易出錯)進化到了可使用系統 2 思維(緩慢、深思熟慮、有意識、可靠)。這讓它能夠解決以前無法解決的問題。

從今天 ChatGPT 的用戶體驗來看,這是向前邁進一小步。在簡單的 Prompt 下,用戶可能不會注意到太大的差異,但如果問一些棘手的數學或者代碼問題,區別就开始明顯了。更重要的是,未來發展的道路已經开始顯現。

總而言之,今晚 OpenAI 丟出的這個重磅炸彈,已經讓整個 AI 社區震撼,紛紛表示 tql、睡不着覺,深夜已經开始抓緊學習。接下來,就讓我們看下 OpenAI o1 大模型的技術細節。

OpenAI o1 工作原理

在技術博客《Learning to Reason with LLMs》中,OpenAI 對 o1 系列語言模型做了詳細的技術介紹。

OpenAI o1 是經過強化學習訓練來執行復雜推理任務的新型語言模型。特點就是,o1 在回答之前會思考 —— 它可以在響應用戶之前產生一個很長的內部思維鏈。

也就是該模型在作出反應之前,需要像人類一樣,花更多時間思考問題。通過訓練,它們學會完善自己的思維過程,嘗試不同的策略,並認識到自己的錯誤。

在 OpenAI 的測試中,該系列後續更新的模型在物理、化學和生物學這些具有挑战性的基准任務上的表現與博士生相似。OpenAI 還發現它在數學和編碼方面表現出色。

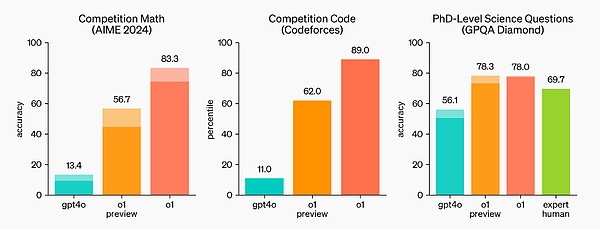

在國際數學奧林匹克(IMO)資格考試中,GPT-4o 僅正確解答了 13% 的問題,而 o1 模型正確解答了 83% 的問題。

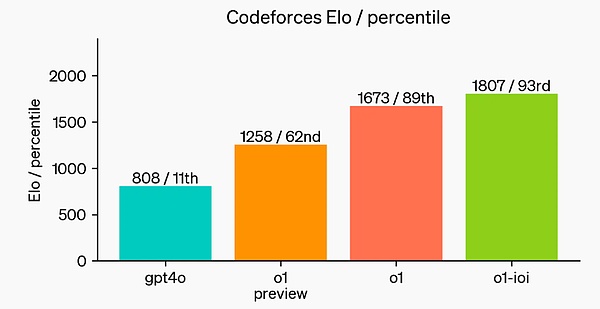

模型的編碼能力也在比賽中得到了評估,在 Codeforces 比賽中排名 89%。

OpenAI 表示,作爲早期模型,它還不具備 ChatGPT 的許多實用功能,例如瀏覽網頁獲取信息以及上傳文件和圖片。

但對於復雜的推理任務來說,這是一個重大進步,代表了人工智能能力的新水平。鑑於此,OpenAI 將計數器重置爲 1,並將該系列模型命名爲 OpenAI o1。

重點在於,OpenAI 的大規模強化學習算法,教會模型如何在數據高度有效的訓練過程中利用其思想鏈進行高效思考。換言之,類似於強化學習的 Scaling Law。

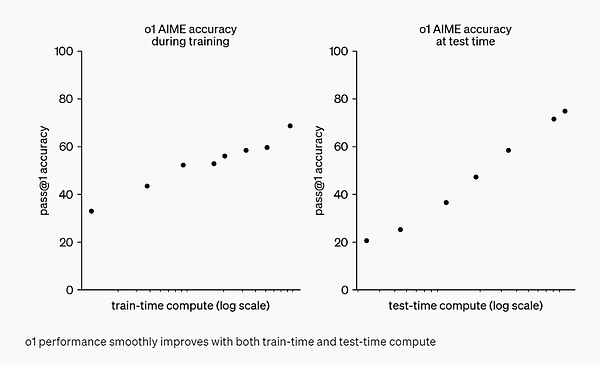

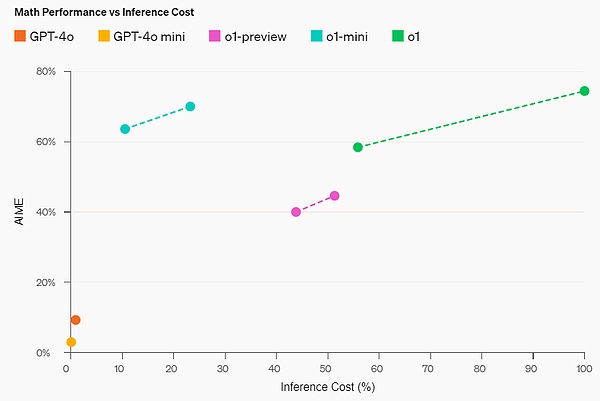

OpenAI 發現,隨着更多的強化學習(訓練時計算)和更多的思考時間(測試時計算),o1 的性能持續提高。而且擴展這種方法的限制與大模型預訓練的限制有很大不同,OpenAI 也還在繼續研究。

評估

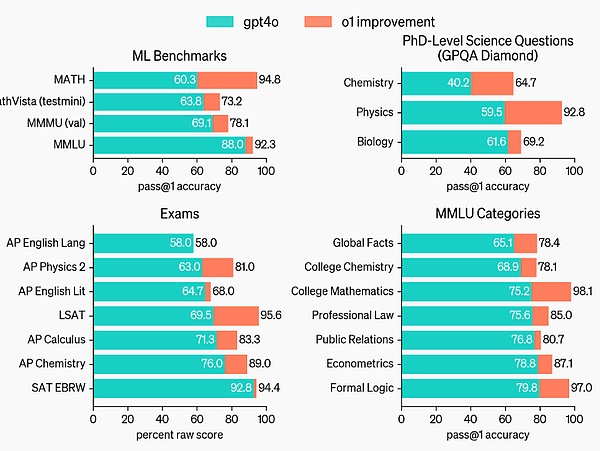

爲了突出相對於 GPT-4o 的推理性能改進,OpenAI 在一系列不同的人類考試和機器學習基准測試中測試了 o1 模型。實驗結果表明,在絕大多數推理任務中,o1 的表現明顯優於 GPT-4o。

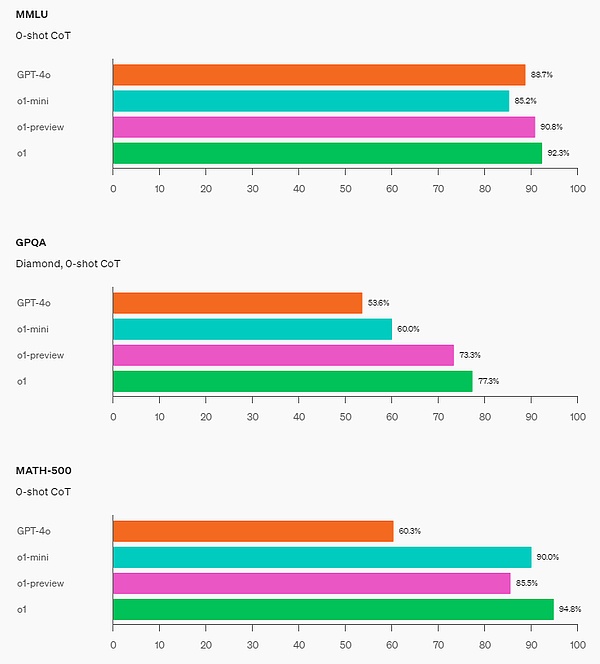

o1 在具有挑战性的推理基准上比 GPT-4o 有了很大的改進。

o1 在廣泛的基准測試上比 GPT-4o 有所改進,包括 54/57 MMLU 子類別,圖示出了 7 個以供說明。

在許多推理密集型基准測試中,o1 的表現可與人類專家相媲美。最近的前沿模型在 MATH 和 GSM8K 上表現得非常好,以至於這些基准測試在區分模型方面不再有效。因此,OpenAI 在 AIME 上評估了數學成績,這是一項旨在測試美國最聰明高中數學學生的考試。

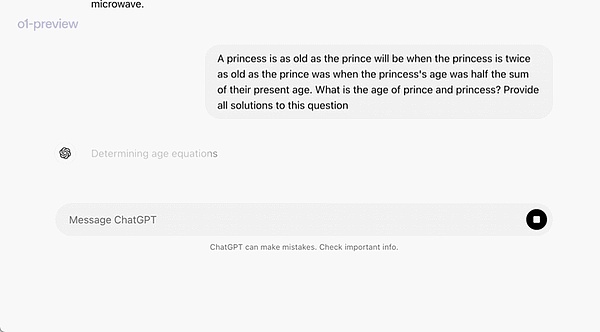

在一個官方演示中,o1-preview 解答了一個非常困難的推理問題:當公主的年齡是王子的兩倍時,公主的年齡與王子一樣大,而公主的年齡是他們現在年齡總和的一半。王子和公主的年齡是多少?提供這個問題的所有解。

在 2024 年 AIME 考試中,GPT-4o 平均只解決了 12% (1.8/15) 的問題,而 o1 在每個問題只有一個樣本的情況下平均爲 74% (11.1/15),在 64 個樣本之間達成一致的情況下爲 83% (12.5/15),在使用學習的評分函數對 1000 個樣本重新排序時爲 93% (13.9/15)。13.9 分可以躋身全美前 500 名,並且高於美國數學奧林匹克競賽分數线。

OpenAI 還在 GPQA Diamond 基准上評估了 o1,這是一個困難的智力基准,用於測試化學、物理和生物學方面的專業知識。爲了將模型與人類進行比較,OpenAI 聘請了擁有博士學位的專家來回答 GPQA Diamond 基准問題。

實驗結果表明:o1 超越了人類專家的表現,成爲第一個在該基准測試中做到這一點的模型。

這些結果並不意味着 o1 在所有方面都比博士更有能力 —— 只是該模型更擅長解決一些博士應該解決的問題。在其他幾個 ML 基准測試中,o1 實現了新的 SOTA。

啓用視覺感知能力後,o1 在 MMMU 基准上得分爲 78.2%,成爲第一個與人類專家相當的模型。o1 還在 57 個 MMLU 子類別中的 54 個上優於 GPT-4o。

思維鏈(CoT)

與人類在回答難題之前會長時間思考類似,o1 在嘗試解決問題時會使用思維鏈。通過強化學習,o1 學會磨練其思維鏈並改進其使用的策略。o1 學會了識別和糾正錯誤,並可以將棘手的步驟分解爲更簡單的步驟。o1 還學會了在當前方法不起作用時嘗試不同的方法。這個過程極大地提高了模型的推理能力。

編程能力

基於 o1 進行了初始化並進一步訓練了其編程技能後,OpenAI 訓練得到了一個非常強大的編程模型(o1-ioi)。該模型在 2024 年國際信息學奧林匹克競賽(IOI)賽題上得到了 213 分,達到了排名前 49% 的水平。並且該模型參與競賽的條件與 2024 IOI 的人類參賽者一樣:需要在 10 個小時內解答 6 個高難度算法問題,並且每個問題僅能提交 50 次答案。

針對每個問題,這個經過專門訓練的 o1 模型會採樣許多候選答案,然後基於一個測試時選取策略提交其中 50 個答案。選取標准包括在 IOI 公共測試案例、模型生成的測試案例以及一個學習得到的評分函數上的性能。

研究表明,這個策略是有效的。因爲如果直接隨機提交一個答案,則平均得分僅有 156。這說明在該競賽條件下,這個策略至少值 60 分。

OpenAI 發現,如果放寬提交限制條件,則模型性能更是能大幅提升。如果每個問題允許提交 1 萬次答案,即使不使用上述測試時選取策略,該模型也能得到 362.14 分——可以得金牌了。

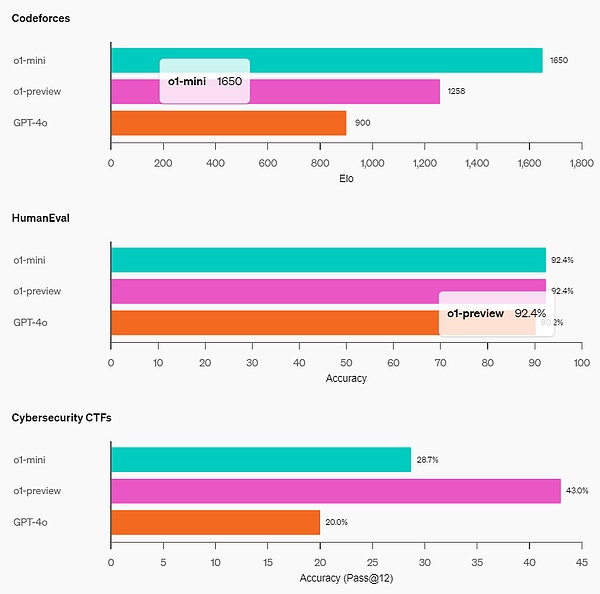

最後,OpenAI 模擬了 Codeforces 主辦的競爭性編程競賽,以展示該模型的編碼技能。採用的評估與競賽規則非常接近,允許提交 10 份代碼。GPT-4o 的 Elo 評分爲 808,在人類競爭對手中處於前 11% 的水平。該模型遠遠超過了 GPT-4o 和 o1——它的 Elo 評分爲 1807,表現優於 93% 的競爭對手。

在編程競賽上進一步微調使得 o1 能力又增,並在 2024 年國際信息學奧林匹克競賽(IOI)規則下排名前 49%。

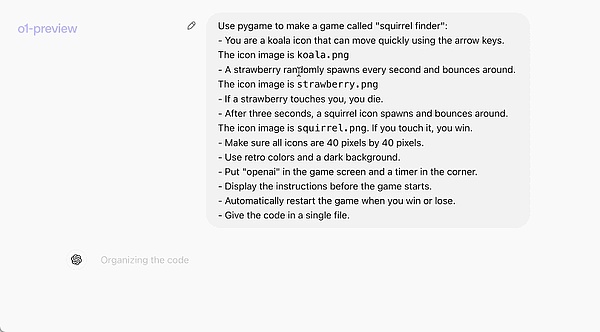

下面這個官方示例直觀地展示了 o1-preview 的編程能力:一段提示詞就讓其寫出了一個完整可運行的遊戲。

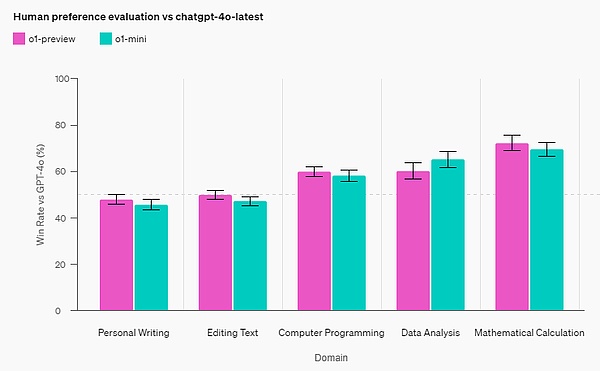

人類偏好評估

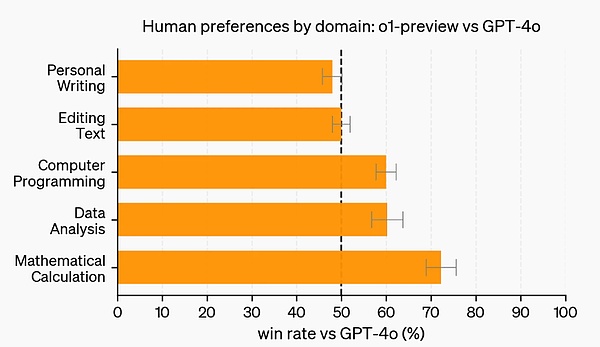

除了考試和學術基准之外,OpenAI 還在更多領域的具有挑战性的开放式提示上評估了人類對 o1-preview 和 GPT-4o 的偏好。

在這次評估中,人類訓練者對 o1-preview 和 GPT-4o 的提示進行匿名回答,並投票選出他們更喜歡的回答。在數據分析、編程和數學等推理能力較強的類別中,o1-preview 的受歡迎程度遠遠高於 GPT-4o。然而,o1-preview 在某些自然語言任務上並不受歡迎,這表明它並不適合所有用例。

在需要更強大推理能力的領域,人們更青睞 o1-preview。

安全

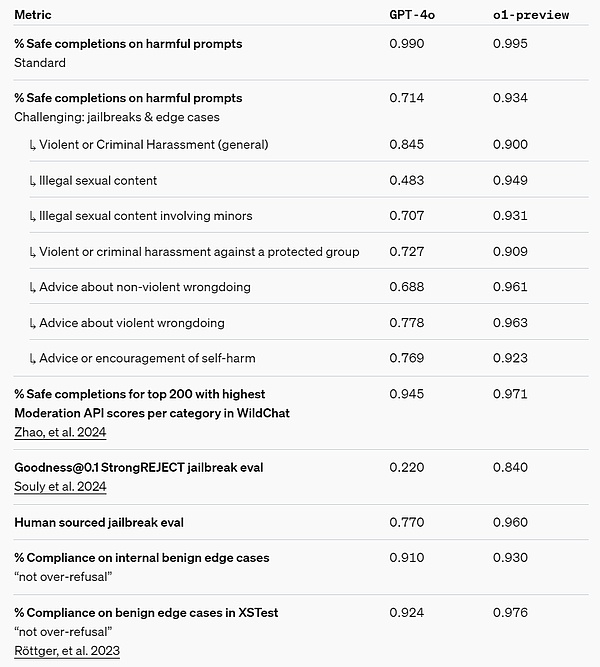

思維鏈(CoT)推理爲安全和對齊提供了新的思路。OpenAI 發現,將模型行爲策略整合到推理模型的思維鏈中,可以高效、穩健地教導人類價值觀和原則。通過向模型教導自己的安全規則以及如何在上下文中推理它們,OpenAI 發現推理能力直接有利於模型穩健性的證據:o1-preview 在關鍵越獄評估和用於評估模型安全拒絕邊界的最嚴格內部基准上取得了顯著的改進。

OpenAI 認爲,使用思維鏈可以爲安全和對齊帶來重大進步,因爲 1)它能夠以清晰的方式觀察模型思維,並且 2)關於安全規則的模型推理對於分布外場景更具穩健性。

爲了對自己的改進進行壓力測試, OpenAI 在部署之前根據自己的安全准備框架進行了一系列安全測試和紅隊測試。結果發現,思維鏈推理有助於在整個評估過程中提高能力。尤其值得注意的是,OpenAI 觀察到了有趣的獎勵黑客攻擊實例。

安全准備框架鏈接:https://openai.com/safety/

隱藏思維鏈

OpenAI 認爲隱藏思維鏈爲監控模型提供了獨特的機會。假設它是忠實且清晰的,隱藏思維鏈使得能夠「讀懂」模型的思想並了解其思維過程。例如,人們將來可能希望監控思維鏈以尋找操控用戶的跡象。

但要做到這一點,模型必須能夠自由地以未改變的形式表達其思想,因此不能在思維鏈方面訓練進行任何政策合規性或用戶偏好性訓練。OpenAI 也不想讓用戶直接看到不一致的思維鏈。

因此,在權衡用戶體驗、競爭優勢和追求思維鏈監控的選項等多種因素後,OpenAI 決定不向用戶展示原始的思維鏈。OpenAI 承認這個決定有不好的地方,因此努力通過教導模型在答案中重現思維鏈中的任何有用想法來部分彌補。同時,對於 o1 模型系列,OpenAI 展示了模型生成的思維鏈摘要。

可以說,o1 顯著提升了 AI 推理的最新水平。OpenAI 計劃在不斷迭代的過程中發布此模型的改進版本,並期望這些新的推理能力將提高將模型與人類價值觀和原則相結合的能力。OpenAI 相信 o1 及其後續產品將在科學、編程、數學和相關領域爲 AI 解鎖更多新用例。

OpenAI o1-mini

o1 是一個系列模型。這次 OpenAI 還一並發布了一個 mini 版 OpenAI o1-mini。該公司在博客中給出了 preview 和 mini 版的不同定義:「爲了給开發者提供更高效的解決方案,我們也發布了 OpenAI o1-mini,這是一個尤其擅長編程的更快、更便宜的推理模型。」整體來看,o1-mini 的成本比 o1-preview 低 80%。

由於 o1 等大型語言模型是在大量文本數據集上預訓練,雖然具有廣泛世界知識,但對於實際應用來說,可能成本高昂且速度慢。

相比之下,o1-mini 是一個較小的模型,在預訓練期間針對 STEM 推理進行了優化。在使用與 o1 相同的高計算強化學習 (RL) pipeline 進行訓練後, o1-mini 在許多有用的推理任務上實現了相媲美的性能,同時成本效率顯著提高。

比如在需要智能和推理的基准測試中,與 o1-preview 和 o1 相比,o1-mini 表現良好。但它在需要非 STEM 事實知識的任務上表現較差。

數學能力:在高中 AIME 數學競賽中,o1-mini (70.0%) 與 o1 (74.4%) 不相上下,但價格卻便宜很多,並且優於 o1-preview (44.6%)。o1-mini 的得分(約 11/15 個問題)大約位於美國前 500 名高中生之列。

編碼能力:在 Codeforces 競賽網站上,o1-mini 的 Elo 得分爲 1650,與 o1 (1673) 不相上下,並且高於 o1-preview (1258)。此外,o1-mini 在 HumanEval 編碼基准和高中網絡安全奪旗挑战 (CTF) 中也表現出色。

STEM:在一些需要推理的學術基准上,例如 GPQA(科學)和 MATH-500,o1-mini 的表現優於 GPT-4o。o1-mini 在 MMLU 等任務上的表現則不如 GPT-4o,並且由於缺乏廣泛的世界知識而在 GPQA 基准上落後於 o1-preview。

人類偏好評估:OpenAI 讓人類評分員在各個領域具有挑战性的开放式提示上比較 o1-mini 和 GPT-4o。與 o1-preview 類似,在推理密集型領域,o1-mini 比 GPT-4o 更受歡迎;但在以語言爲中心的領域,o1-mini 並不比 GPT-4o 更受歡迎。

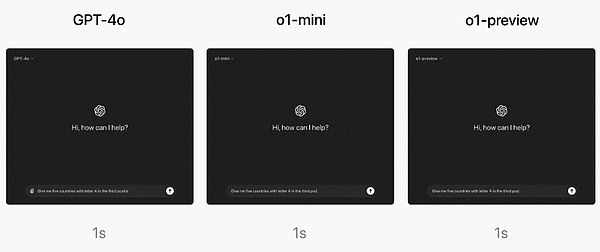

在速度層面,OpenAI 比較了 GPT-4o、o1-mini 和 o1-preview 對一個單詞推理問題的回答。結果顯示,GPT-4o 回答不正確,而 o1-mini 和 o1-preview 均回答正確,並且 o1-mini 得出答案的速度快了大約 3-5 倍。

如何使用 OpenAI o1?

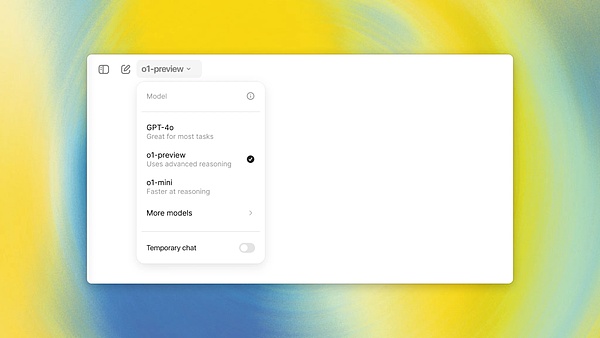

ChatGPT Plus 和 Team(個人付費版與團隊版)用戶馬上就可以在該公司的聊天機器人產品 ChatGPT 中开始使用 o1 模型了。你可以手動選取使用 o1-preview 或 o1-mini。不過,用戶的使用量有限。

目前,每位用戶每周僅能給 o1-preview 發送 30 條消息,給 o1-mini 發送 50 條消息。

是的,很少!不過 OpenAI 表示正在努力提升用戶的可使用次數,並讓 ChatGPT 能自動針對給定提示詞選擇使用合適的模型。

至於企業版和教育版用戶,要到下周才能开始使用這兩個模型。

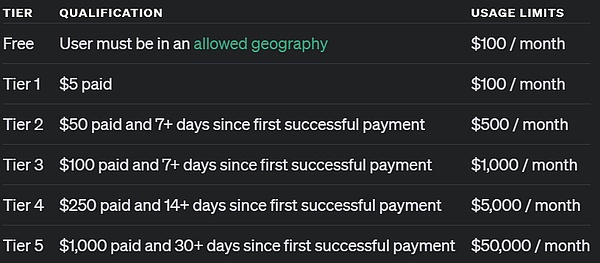

至於通過 API 訪問的用戶,OpenAI 表示達到了 5 級 API 使用量的开發者可以即刻开始使用這兩個模型开始开發應用原型,但同樣也被限了速:20 RPM。什么是 5 級 API 使用量?簡單來說,就是已經消費了 1000 美元以上並且已經是超過 1 個月的付費用戶。請看下圖:

OpenAI 表示對這兩個模型的 API 調用並不包含函數調用、流式傳輸(streaming)、系統支持消息等功能。同樣,OpenAI 表示正在努力提升這些限制。

未來

OpenAI 表示,未來除了模型更新之外,還將增加網絡瀏覽、文件和圖像上傳等功能,以讓這些模型變得更加有用。

「除了新的 o1 系列模型,我們計劃繼續开發和發布我們的 GPT 系列模型。」

參考內容:

https://openai.com/index/introducing-openai-o1-preview/

https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/

https://openai.com/index/learning-to-reason-with-llms/

https://x.com/sama/status/1834283100639297910

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:OpenAI震撼發布o1大模型 強化學習突破LLM推理極限

地址:https://www.sgitmedia.com/article/40911.html

相關閱讀:

- IntoTheBlock 聯創:Web3基礎設施正在被過度建造 我們正在盲目行事 2024-12-20

- 國際清算銀行最新提出的央行數字貨幣框架究竟是什么? 2024-12-20

- SOL 質押完整指南:從機制和收益等方面解析 Solana 質押生態 2024-12-20

- 特朗普正式獲得總統職位 BTC儲備競賽即將开啓 2024-12-20

- 預防量子計算威脅實用指南 2024-12-20

- 特朗普兩年時間通過加密貨幣賺了多少錢? 2024-12-20

- Chainalysis:朝鮮黑客從加密平台竊取的錢都幹什么了? 2024-12-20

- 估值45億美元,OpenAI和谷歌大佬聯手創立的AI Agent公司爲何這么牛? 2024-12-20